HPE 利用 NVIDIA GPU 引擎进军企业 AI

本周对于服务器 OEM 来说又是一个重要的会议,这也意味着 OEM 又一次宣布与 AI 计算引擎巨头 Nvidia 建立紧密的合作伙伴关系。

本周,惠普企业 (Hewlett Packard Enterprise) 试图在 GPU 市场中同时占据两个阵营,首先将重点放在 AMD 引擎上,用于至少部分最大的机器(通常是美国和欧洲国家实验室的混合 HPC/AI 系统),然后专注于 Nvidia 引擎,以满足企业客户日益增长的 AI 愿望和积压订单。

在 3 月份举行的 Nvidia GTC 2024 开发者大会上,创始人兼首席执行官黄仁勋强调,他的公司不仅仅是一家 GPU 制造商或云计算公司,而是一家“平台公司”。Nvidia 拥有广泛的硬件产品组合,从需求旺盛的 GPU 到超级计算机,再到其NVLink 互连,再到CUDA和 AI Enterprise 等软件工具,以及针对医疗保健、汽车和金融服务等特定行业的软件包,所有这些都体现了其长达十年的对 AI 的关注。

自 2022 年底以来,生成式 AI 创新和应用呈爆炸式增长,几乎所有 IT 供应商都朝着这个方向迅速转变,这使得 Nvidia 成为硬件和软件公司的首选 AI 合作伙伴。在 GTC 上,Nvidia 宣布扩大与 Google 和 SAP 等公司的合作伙伴关系,在上个月的 Dell Technologies World 大会上,戴尔与 Nvidia 合作扩大了其 Dell AI Factory(也在 GTC 上亮相),包括新硬件。

本月初,思科系统推出了 Nexus HyperFabric AI 集群,它结合了其自己的 AI 网络和 Nvidia 的加速计算和 AI Enterprise 软件平台以及 VAST Data 的存储,旨在让企业更轻松地运行 AI 工作负载。

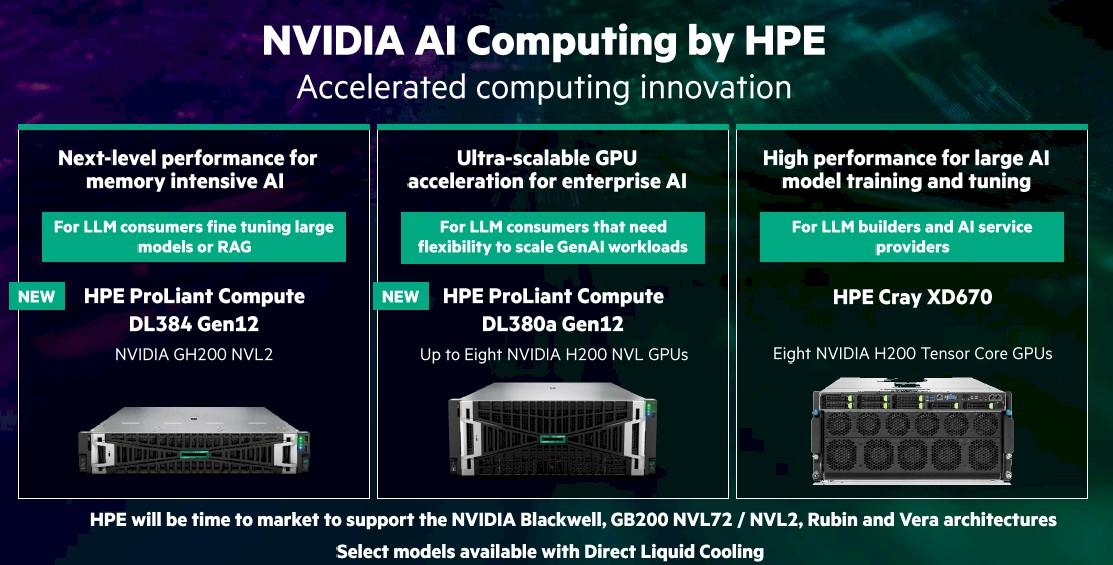

现在轮到 HPE 了。本周,在拉斯维加斯举办的 Discover 2024 展会上,两家公司宣布推出 Nvidia AI Computing by HPE,这是一套联合开发的 AI 产品和上市战略,旨在推动企业 AI 计算。其基础是三台 HPE 服务器,包括搭载八台 Nvidia H200 NVL Tensor Core GPU 的 ProLiant DL380a Gen12 和搭载 GH200 NVL2 加速器的 DL384 Gen 12。

Cray XD670 拥有八个 H200 NVL Tensor 核心,面向构建 LLM 的企业。HPE 还将采用即将上市的 Nvidia 芯片,包括其 GB200 NVL72 和 NVL2 GPU 以及其Blackwell、Rubin 和 Vera 加速器。

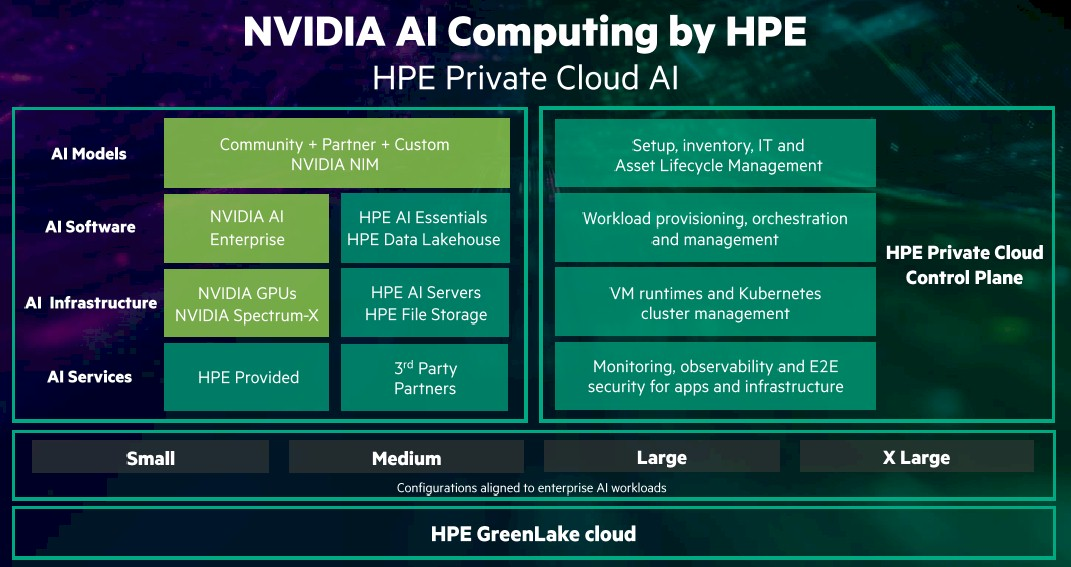

与之相关的是 HPE Private Cloud AI,其中包括 Nvidia 的 AI Enterprise 软件平台和 Nvidia Inference Microservices (NIM),它们在 GTC 上发布,本质上是虚拟化容器,包括企业构建和运行推理工作负载所需的一切(包括 API、干扰引擎和优化的 AI 模型)。HPE 还带来了其 AI Essentials 软件和基础设施,其中包括 Nvidia 的 Spectrum-X 以太网网络、HPE 的 GreenLake文件存储服务和 ProLiant 服务器。

企业将有四种配置尺寸可供选择——小型、中型、大型和超大型,并具有相应的 GPU 数量、存储空间、网络功能和功耗。企业可以根据自己的需求选择配置,从适合推理工作负载的较小尺寸到适合推理、检索增强生成 (RAG) 和精细调整任务的最大尺寸。

HPE 混合云执行副总裁兼总经理兼首席技术官 Fidelma Russo 在展会开始前的简报会上表示,企业只需三次点击即可启动 HPE 私有云 AI。

“每种配置都是模块化的,它允许您随着时间的推移扩展或增加容量,并通过 HPE GreenLake 云保持一致的云管理体验,”Russo 表示。“您可以从几个小型模型推理单元开始,然后扩展到具有更高吞吐量的多个用例,并且可以在一个解决方案中进行 RAG 或 LLM 微调。我们提供多种使用方式和一系列支持,从自我管理到将其作为完全托管的服务提供。”

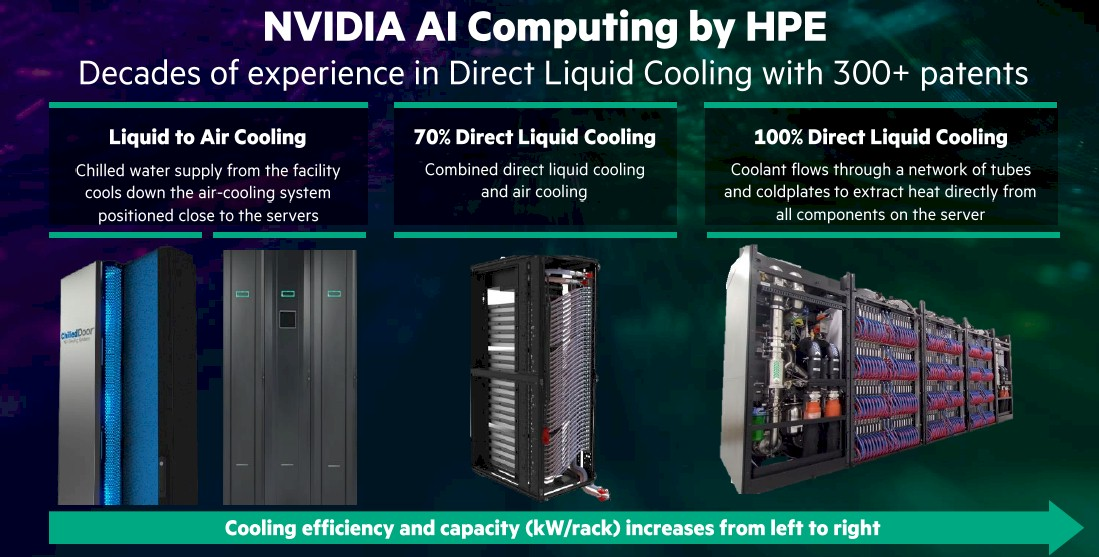

HPE 执行副总裁兼计算、HPC 和 AI 总经理 Neil MacDonald 补充道,随着 HPE 私有云 AI 的成熟,该供应商将把液体冷却技术引入其中。

MacDonald 表示:“直接液冷对于企业 AI 平台的未来至关重要。我们拥有 300 多项专利,从液冷到风冷,使用设施提供的冷冻水来冷却风冷服务器附近的风冷系统。我们构建了 70% 直接液冷系统,将直接液冷和风冷相结合。我们拥有 100% 直接液冷系统,其中冷却剂流经管道和冷板网络,直接从服务器上的所有组件中提取热量。”

HPE-Nvidia 联合推出的产品就是 Jensen 所说的 AI 改变数据中心和云端事物外观和运行方式的例子。

“这是 60 年来最伟大的基础计算平台转型,从通用计算到加速计算,从 CPU 处理到 CPU 和 GPU 处理,从指令、工程化指令到现在基于数据训练的大型语言模型,从指令驱动计算到现在的意图驱动计算,计算堆栈的每一层都发生了变化,正如我们非常清楚的那样,现在可以编写和开发的应用程序类型是全新的,”詹森在主题演讲台上站在 HPE 总裁兼首席执行官安东尼奥·内里 (Antonio Neri) 旁边说道。“开发应用程序的方式是全新的,因此计算堆栈的每一层都在经历转变。”

向 AI 的快速转变对 Nvidia 来说非常有利,该公司第一季度收入同比增长 262%,达到 260 亿美元,市值达到 3 万亿美元。其 H100 Tensor Core GPU(AI 工作负载的首选加速器,该公司供应了高达 90% 的 GPU)的需求继续超过供应。

英特尔和AMD拥有 GPU,谷歌、微软和亚马逊网络服务(AWS) 等超大规模云提供商正在为 AI 制造自己的芯片,而且似乎有越来越多的初创公司正在寻找市场立足点。然而,其中一些公司缺乏 Nvidia 也具备的其他因素,例如系统、软件和 AI 生态系统,这将使该公司很难被击败。

HPE 的 MacDonald 在新闻发布会上被问及,既然 HPE 也与 AMD 在 AI 加速器方面建立了合作伙伴关系,那么为什么 HPE 会全力与 Nvidia 合作。

“企业生成式 AI 的成功不仅依赖于加速器芯片,还依赖于结构、系统设计、模型、软件工具以及运行时对这些模型的优化,”他说。“我们很高兴能与 Nvidia 密切合作,我们拥有一套非常强大的能力,这些能力使我们的企业客户能够在企业旅程中更快地前进。值得注意的是,HPE Private Cloud AI 不是一种参考架构,它不会让客户承担将各个部分拼凑在一起来组装 AI 基础设施的负担,无论是 GPU、软件还是不同的连接。HPE 和 Nvidia 共同开发了一个交钥匙 AI 私有云,只需三次点击即可启动并运行,从而为客户完成了艰苦的工作。这远远超出了加速器的问题。”

【公司名称】四川旭辉星创科技有限公司

【代理级别】成都惠普HPE服务器工作站总代理

【销售经理】熊经理

【联系方式】座机:028-85596747 手机:18244236404

【公司地址】成都市人民南路 科华路口 群益商务大厦403